Новейшая китайская нейросеть DeepSeek стала горячей темой на всемирной сцене. Как мощная открытая большая языковая модель (LLM), предназначенная для различных ИИ-приложений, от обработки естественного языка до генерации контента, она существует в моделях с разными размерами, что делает ее адаптируемой ко многим вычислительным средам.

В то время, как DeepSeek-R1 обычно работает на высокопроизводительном оборудовании, она также может быть запущена на Raspberry Pi 5 с надлежащей оптимизацией. Это руководство проведет вас через настройку совместимого окружения и установку необходимых инструментов до запуска DeepSeek-R1 на Raspberry Pi 5 с использованием платформы Ollama. Смотрите ли вы в сторону легкой модели с быстрыми ответами или на продвинутую версия с улучшенной точностью, эта статья поможет вам начать.

С целью избежания возможных конфликтов с исходными настройками системы, лучше создать виртульное окружение для развертывания модели. В дальнейшем это гарантирует, что любые изменения, сделанные для DeepSeek, не повлияют на другие приложения.

Создание директории проекта и виртуального окружения

Откройте окно терминала и выполните следующие команды

mkdir /home/pi/my_project

cd /home/pi/my_project/

python -m venv /home/pi/my_project/Активация виртуального окружения

После создания виртуального окружения активируйте его

source /home/pi/my_project/bin/activateДеактивация

Для деактивации виртуального окружения используйте

deactivateОбязательно выполните все шаги настройки модели в этом виртуальном окружении.

DeepSeek-R1 может быть запущена с помощью фреймворка Ollama, который поддерживает файлы GGUF-форматной модели. Если вы выберите модель формата safetensors, вам нужно конвертировать ее в GGUF используя llama.cpp.

Проверка совместимости системы

Перед продолжением убедитесь, что система вашей Raspberry Pi 64-разрядная, выполнив команду

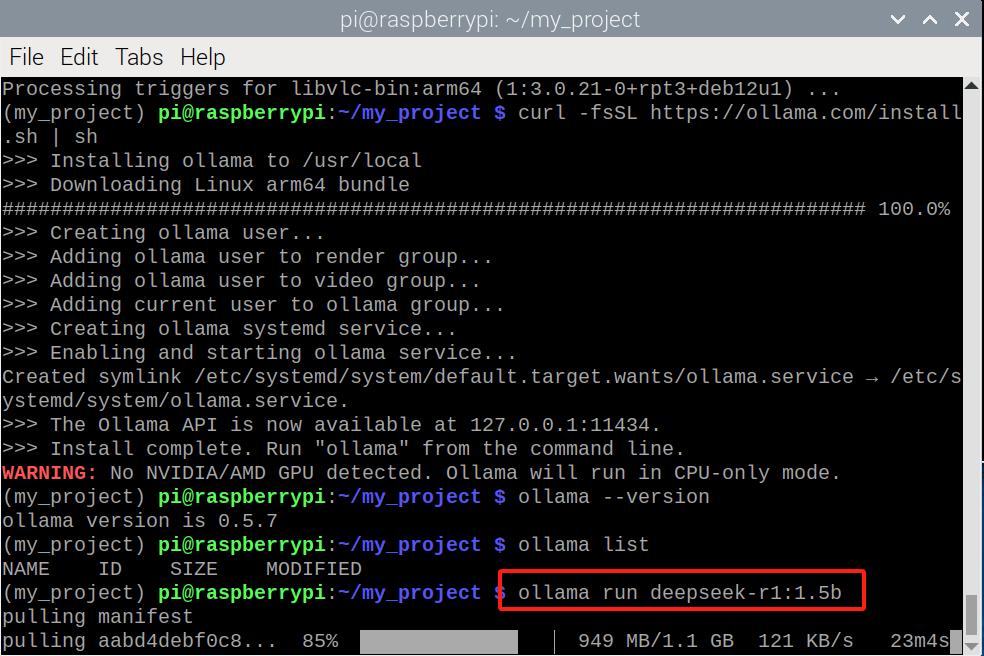

uname -mУстановка Ollama

Прежде всего, обновите ОС вашей Raspberry Pi

sudo apt update

sudo apt upgrade -yЗатем, установите curl (требуется для скачивания Ollama)

sudo apt install curlТеперь скачайте и установите платформу Ollama

curl -fsSL https://ollama.com/install.sh | shПроверка установки

Убедитесь в том, что Ollama установлена успешно

ollama –versionТеперь, когда Ollama готова, переходите к скачиванию модели DeepSeek-R1

Существует два пути получения модели DeepSeek-R1:

Ollama требуется независимо от метода.

Метод 1: Скачивание и запуск напрямую из Ollama

Ollama предоставляет предварительно сконфигурированные модели, тем самым упрощая начальный путь.

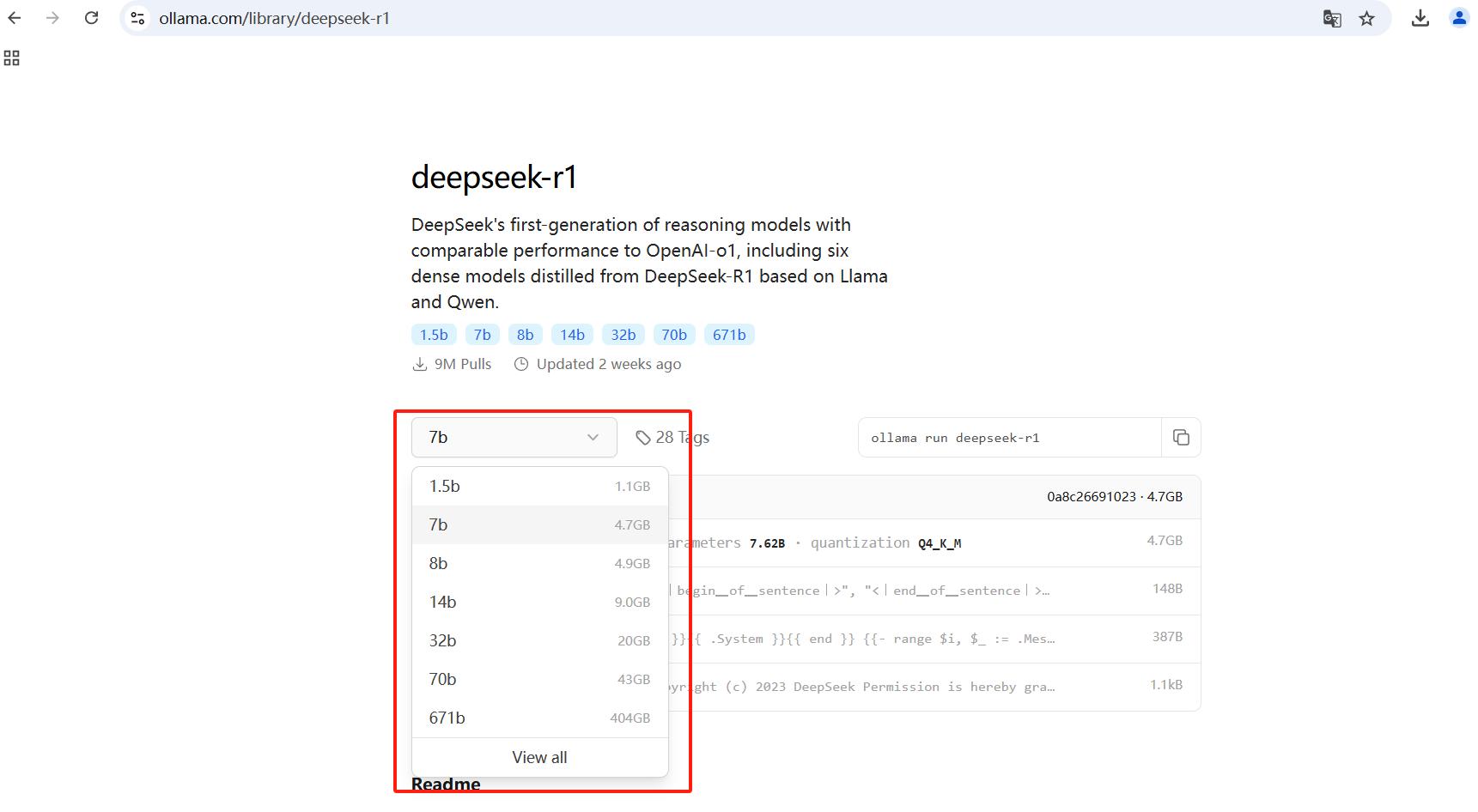

Найдите DeepSeek-R1 на веб-сайте Ollama и подберите модель подходящего размера.

Для запуска модели 1.5B:

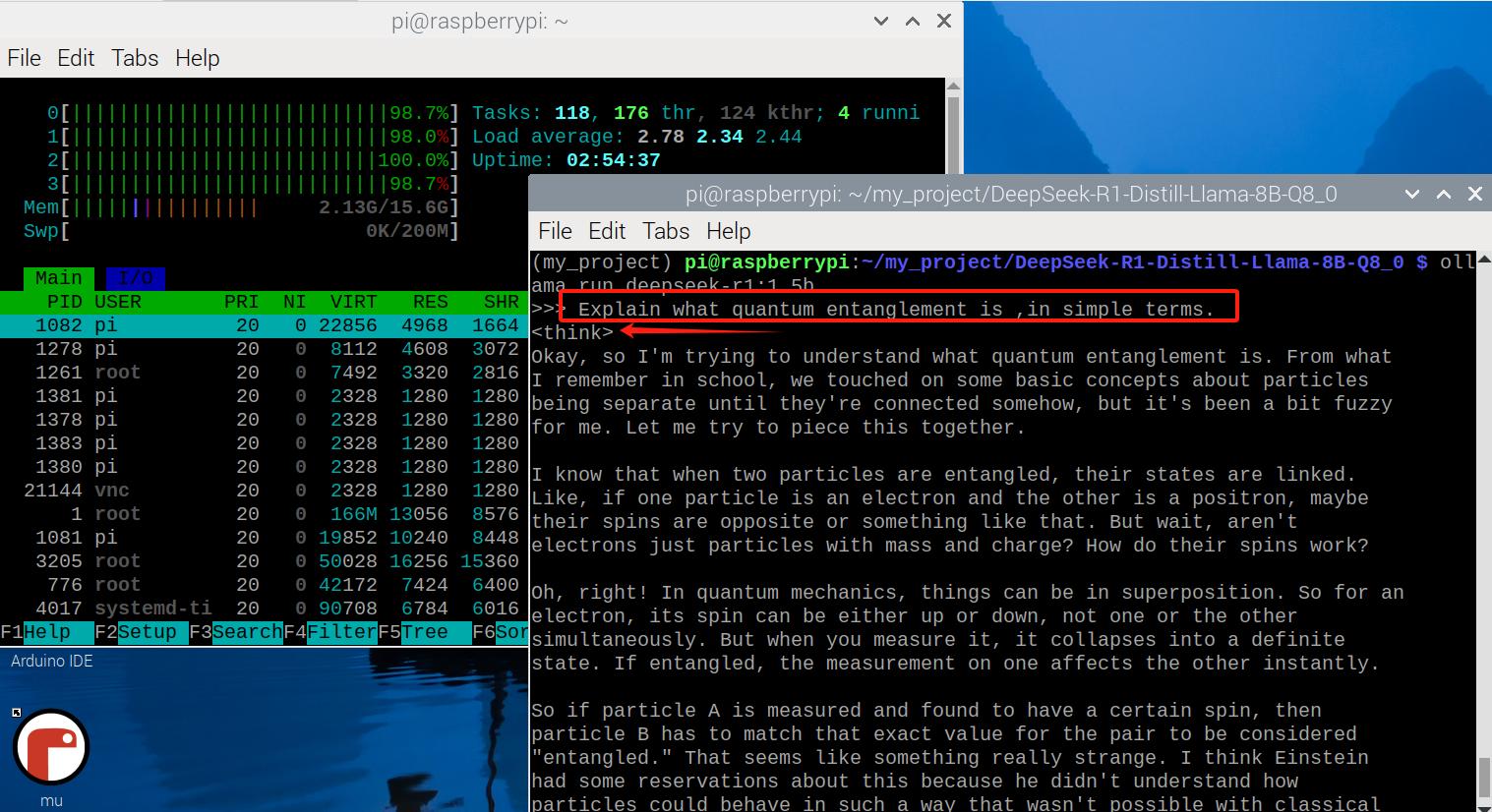

ollama run deepseek-r1:1.5bЗадайте ИИ-модели вопрос наподобие: Explain whate quantum entanglement is, in simple terms (Объясни простыми терминами, что такое квантовая запутанность). Она сразу же ответит, также отобразив свой мыслительный процесс.

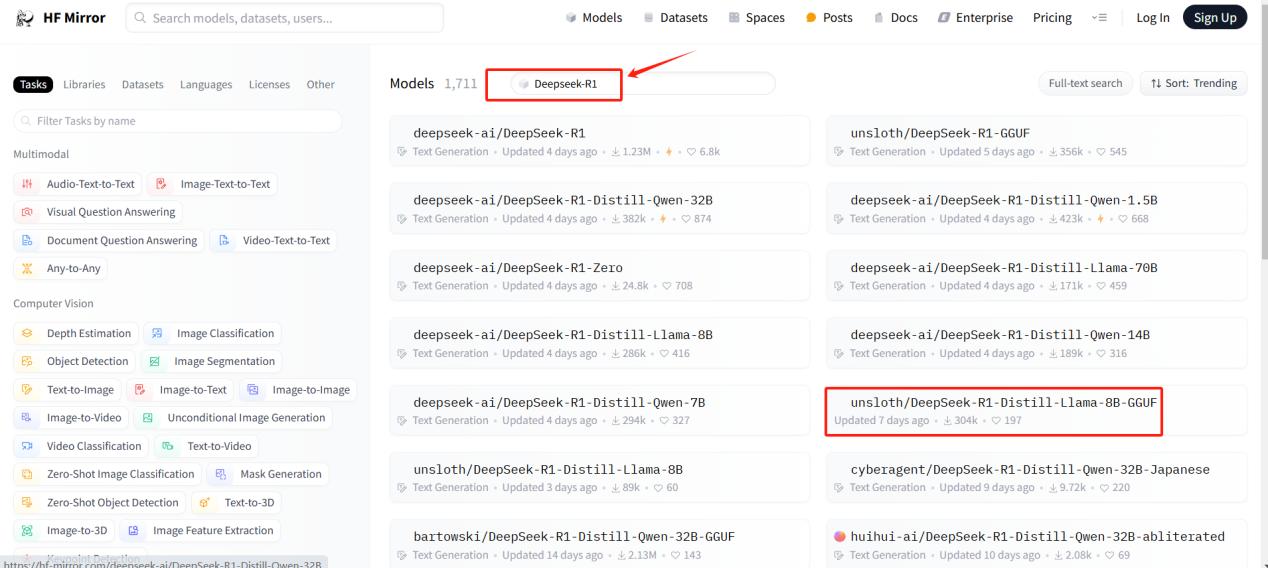

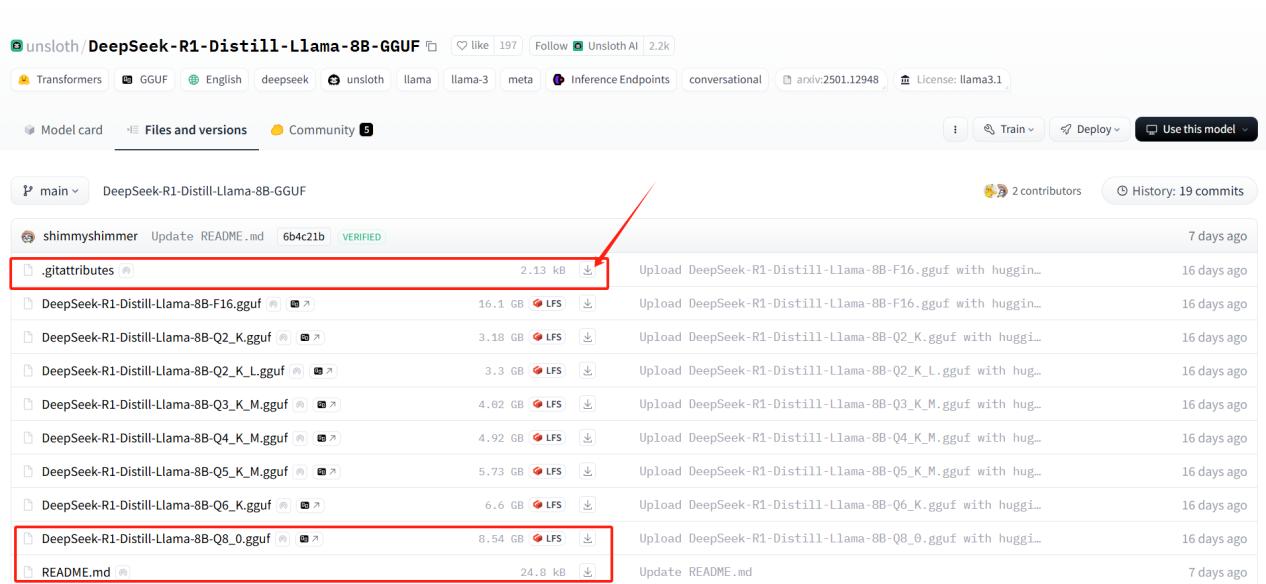

Метод 2: Скачивание модели из HuggingFace

Загрузка из HuggingFace позволяет вам выбрать конкретный размер модели. Польза возможности выбора в том, что Raspbetty Pi 5, даже с 16ГБ оперативной памяти, не способна эффективно справиться с крупными моделями.

Выбор модели из HuggingFace

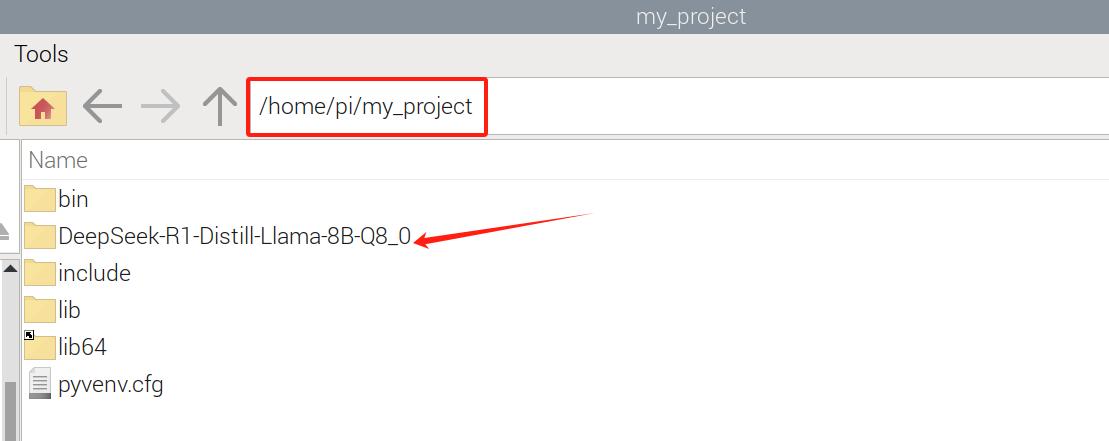

Передача файлов модели в Raspberry Pi

После скачивания трех фалов, переместите их в вашу Raspberry Pi при помощи FileZilla или другого приложения для перемещения файлов.

После того, как файлы модели окажутся в Raspberry Pi, нам нужно импортировать их в Ollama

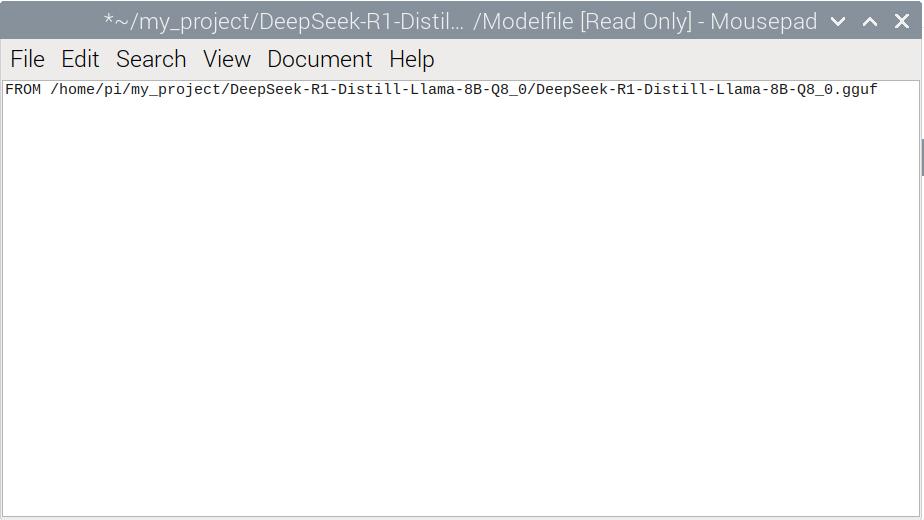

Создание Modelfile

Сначала создайте файл с именем Modelfile в папке модели и предоставьте полные права доступа:

sudo touch /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/Modelfile

sudo chmod 777 /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/ModelfileДобавление конфигурации модели

Откройте Modelfile и добавьте в него строку

FROM /home/pi/my_project/DeepSeek-R1-Distill-Llama-8B-Q8_0/DeepSeek-R1-Distill-Llama-8B-Q8_0.gguf

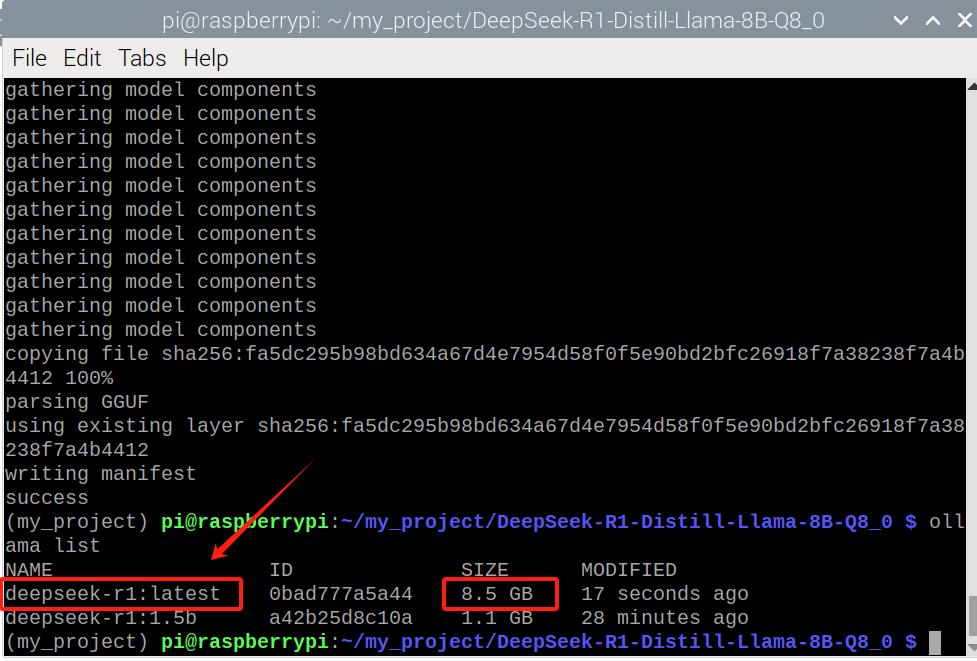

Теперь создайте модель в Ollama:

ollama create DeepSeek-R1 -f ModelfileПроверьте доступность созданной модели

ollama listОбратите внимание на полное название созданной модели. Любые действия с этой моделью (запуск, остановка, удаление...) возможны с указанием ее полного имени.

И наконец запустите модель:

ollama run deepseek-r1:latestЗадавайте DeepSeek-R1 вопросы и наблюдайте ее ответы.

Мы протестировали две версии DeepSeek-R1:

Отличия производительности

| Модель | Размер | Качество ответа | Скорость | Использование памяти |

| 1.5B (Ollama) | Малый | Приличное | Быстрая | Низкое |

| 8B (HuggingFace) | Большой | Лучшее | Медленная | Высокое |

Если у вас в приоритете быстрый ответ, используйте DeepSeek-R1-1.5B. Если вам нужен высококачественный ответ, используйте DeepSeek-R1-8B, но помните про ограничения памяти.

Следуя этой инструкции, вы сможете успешно запустить DeepSeek-R1 на Raspberry Pi 5 с использованием платформы Ollama. Если вас интересует легкая настройка, лучше воспользоваться прямой загрузкой ИИ-модели из Ollama. Однако, HuggingFace предоставляет большую гибкость в выборе ИИ-модели конкретного размера.

Экспериментируйте c вашей моделью и смотрите, на что она способна!

Информация представленная на данном информационном ресурсе преследует исключительно рекламные цели и не является договором-офертой!

© Все права защищены 2015 - 2025г https://compacttool.ru